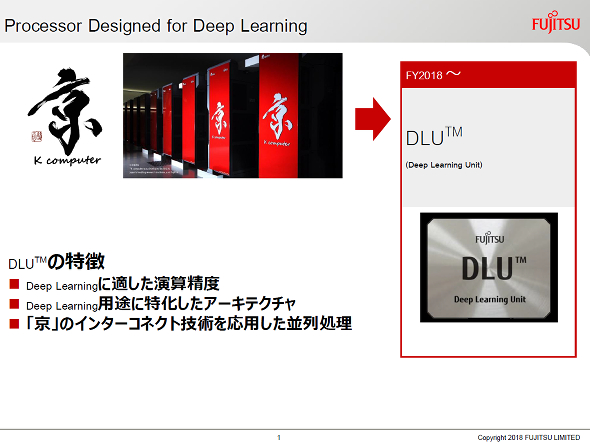

富士通のAIプロセッサ、演算精度とμアーキに工夫:競合より電力性能比10倍の向上(1/2 ページ)

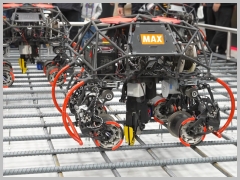

富士通は、同社のプライベートイベント「富士通フォーラム2018 東京」(2018年5月17~18日、東京国際フォーラム)で、ディープラーニング処理に特化したプロセッサ「DLU(Deep Learning Unit)」を展示した。競合となる既存のアクセラレーターと比較して、10倍の電力性能比を実現するとしている。

富士通は、同社のプライベートイベント「富士通フォーラム2018 東京」(2018年5月17~18日、東京国際フォーラム)で、ディープラーニング処理に特化したプロセッサ「DLU(Deep Learning Unit)」を展示した。競合となる既存のアクセラレーターと比較して、10倍の電力性能比を実現するとしている。

DLUは、ディープラーニングに適した独自開発の演算精度「DL-INT」に対応し、ディープラーニングに特化したアーキテクチャ、複数のDLUを接続するためのインターコネクトとしてスーパーコンピュータ(スパコン)京の「Tofu」を応用したネットワークを採用することが特長だ。

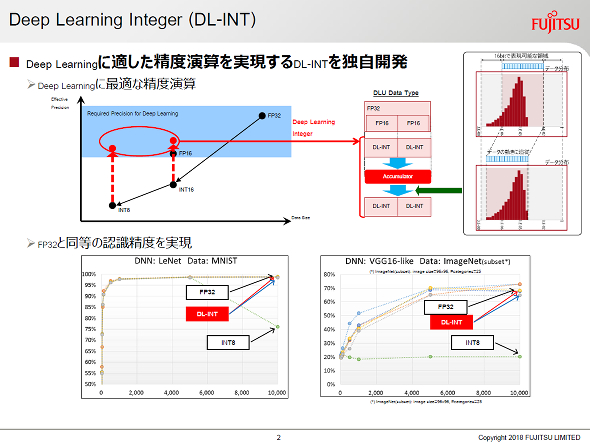

ディープラーニングに適した演算精度「DL-INT」の実装

ディープラーニングの学習では一般的に、高精度実現のためFP32(32ビット浮動小数点)の演算精度で処理がなされる場合が多い。一方で、演算規模や消費電力削減のためFP16やINT16(16ビット整数)など、よりビット幅の小さな演算精度で学習が行われることもあるが、学習の失敗や過学習などにより推論精度の低下が発生することがあった。この問題に対し、GoogleやNVIDIA、Intelといったニューラルネットワーク処理に特化したプロセッサを開発するベンダーではそれぞれ独自の手法で改善を試みている。

富士通は、DL-INTを導入することでこの問題の解決を狙う。DL-INTは、INT8もしくはINT16などの整数形式をビット幅の広いアキュムレーターによって拡張し、データサイズを抑えつつ演算精度の向上を狙ったもの。さらに、演算中のデータを内部的に解析することで、データの精度変化に追従して小数点位置を自動的に制御し、演算精度の低下を防いでいる。これにより、FP32との比較で電力消費を低減しつつも、推論の認識精度をほぼ同等とすることができた。

Copyright © ITmedia, Inc. All Rights Reserved.

Special Contents

- PR -スポンサーからのお知らせ

- PR -Special Contents 1

- PR -Special Contents 2

- PR -記事ランキング

- ついにできた!Rapidus試作ライン稼働、2nm GAAトランジスタの動作を確認

- GaN撤退のTSMC、その後の戦略を考察する

- 2025年は数年に一度の「ビッグチェンジ」イヤー、NVIDIAとAMDの最新GPUを分解

- 世界半導体製造装置市場、2026年は過去最高に

- 「過去の投資は過剰だった」 Intel、ドイツとポーランドの新工場計画を中止

- STがNXPのMEMSセンサー事業買収へ、最大9億5000万ドルで

- パワー半導体受託生産のJSファンダリが破産申請、負債総額約161億円

- ルネサス、Wolfspeed再建支援で25年上期は1753億円の赤字

- 第9世代BiCS FLASH適用512Gb TLC製品、キオクシアがサンプル出荷

- ウシオ電機、オスラムグループのランプ事業を買収