IBMの8ビットAIに向けた取り組み:DNNの学習を成功(2/2 ページ)

低精度への移行

効率化を実現するための方法の一つとして、AI処理に必要な精度を下げるという方法がある。

Welser氏は、「これまでは、精度の高い計算性能が当然とされ、32ビットの浮動小数点演算が標準であり、非常に精度の高い計算向けとして64ビットの倍精度浮動小数点演算が使われていた。しかし数年前から、一般的な方向性として、AI分野では、このような精度が必ずしも重要であるとはいえないとする認識が広まってきている」と説明する。

同氏は、「AIの場合、ニューラルネットワークに関して考慮すべき点は、正しい答えを得た場合に、どのタイミングで画像や言葉を表示するかということだ。イヌとネコのどちらなのかを質問した時に、『ネコ』という答えが正しければ、そこに至るまでの計算については気にする必要がない」と主張する。

理想的には、AIが人間の目を模倣すべきだろう。Welser氏は、「例えば、見通しの良くない窓越しに、歩行者が路上を歩いているのが見えるとする。これは、低精細の画像だといえるが、その歩行者が自分の母親で、こちらに歩いてきているということを判断するには十分な場合が多い。このため、正しい答えさえ得られれば、視覚的に高い精度であるかどうかは大した問題ではない」と述べる。

同氏は、「こうしたことから、AI処理は低精度で行うという方向に向かっていると言える」と説明する。

さらにWelser氏は、「32ビット演算の場合、32ビットで計算しなければならないが、それを16ビットで実行できれば、演算性能はおおむね半分で済む。あるいはチップ面積が半分以下になる可能性もある。もし8ビットまたは4ビットまで減らすことができれば、さらに良い結果を得られるだろう。チップ面積や消費電力、性能、スループットなど、全ての面で迅速に大きな成功を収められる」と述べる。

しかし同氏は、「われわれは、これまで長い間、AIの学習(トレーニング)には32ビットの精度を維持するしか方法がないと考えてきた」と認めている。

IBM Researchは2015年に、既存のCMOS技術に関する新しいデータフロー手法について説明した論文を発表し、低精度でトレーニングと推論を行う方法を発表した。同社が披露した、16ビット精度でトレーニングを行ったモデルは、32ビットでトレーニングを行ったモデルと比べても遜色がないという。

IBMは「その後は精度を下げる手法が、業界標準としてたちまち普及していった。今や、16ビットトレーニングや8ビット推論は、ごく普通に存在していて、新興企業の急増を加速し、ベンチャーキャピタルによる低精度のAIチップへの投資を後押しすることになった」と述べている。このような新しい傾向が出現しているにもかかわらず、高精度のモデルを維持しなければならないという前提の元、16ビット未満のトレーニングはほぼ不可能だと考えられてきた。

Welser氏は、「IBMは、さまざまな手法を開発し、それを研究者がAI処理に適用することによって実現してきた。例えば、8ビットで実行するセクションもあれば、積算向けに16ビットで実行するセクションなどもある。そのため、おおよその精度を失うことはない」と述べている。

つまり、IBMの開発チームが達成した成果は、オペレーション全体に対して広く8ビット計算を適用する場合と比べて、複雑化したといえる。IBMはその代わりに、異なるプロセスに対してさまざまな手法を組み合わせるという方法を発見した。

Welser氏は、「例えば実際に、われわれは現在、あらゆる重み更新処理で8ビットを使用しているが、一部の加算や積算ステップ処理では、まだ16ビットを使う場合もある。16ビットの加算は、16ビットの乗算よりも簡単で、実際に16ビットでの実行が役に立つことから、こうした対応が非常に重要になってきている」と述べている。

同氏は、「さらにもっと重要な点がある。IBMの取り組みの中の重要な要素として挙げられるのは、これらの各オペレーションに対し、最終的にボトルネックを発生させないような方法で、チップ上でデータを非常にスムーズに流すことが可能な、データフローアーキテクチャを発見したことだ」と指摘する。

「最終的には、これまで広く使われてきた16ビットや32ビットの場合と同じレベルの精度を、8ビット浮動小数点を効率的に使用することによって実現できると実証した」(Welser氏)

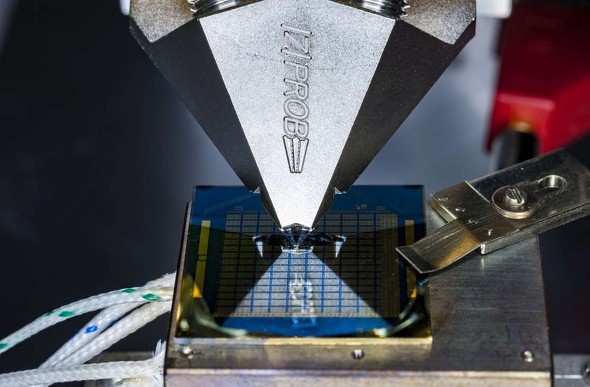

IBMはIEDMで、相変化メモリを使った8ビット精度のインメモリ演算について発表した。

消費電力を削減する鍵は、演算のためにメモリからプロセッサへのデータ移動をなるべく抑えることにある。こうしたデータの移動には時間とエネルギーが必要だからだ。

IBMはIEDMで、新しいタイプのインメモリコンピューティングデバイスを発表した。既存の技術に比べると、100〜1000倍、低いエネルギーで演算が可能だという 出典:IBM Research(クリックで拡大)

IBMはIEDMで、新しいタイプのインメモリコンピューティングデバイスを発表した。既存の技術に比べると、100〜1000倍、低いエネルギーで演算が可能だという 出典:IBM Research(クリックで拡大)より効率的にAI処理を行う必要があることから、インメモリコンピューティングを検討する必要性が高まっている。このような技術を手掛けるAIスタートアップの中で際立っているのがMythicの存在だ。もちろん、Mythic以外にも存在するかもしれない。

Welser氏の見解では、アナログ技術は「エッジにおけるAI」に適しているという。コンピューティングの歴史では、アナログコンピューティングでは低消費電力が要求され、エネルギー効率が高いことが証明されている。だが、それもまた決して正しくはなかった。Welser氏は、「それが、デジタルコンピューティングが最終的にはアナログコンピューティングに勝った理由だ」と述べる。

だがアナログは、インメモリコンピューティングにおいて再び強さを見せていると、Tirias Researchの主席アナリストを務めるKevin Krewell氏は述べている。「メモリアレイはニューラルネットの重みを保持し、アナログ要素は加算やトリガーを実行する」(Krewell氏)

Krewell氏は、「問題は、アナログを適切にキャリブレーションし、プロセスの精度と温度の変化を正しく維持することだ。さらに、アナログとメモリは、デジタル要素のようにはスケールできないことも考慮しなくてはならない」と続けた。

【翻訳:滝本麻貴、田中留美、編集:EE Times Japan】

関連記事

NVIDIA、2017年の半導体売上高でトップ10に

NVIDIA、2017年の半導体売上高でトップ10に

2017年の半導体売上高ランキングトップ10にNVIDIAが初めてランクインした。また、2017年の世界半導体売上高は前年比21.7%増となる4291億米ドルで、メモリチップが前年比60.8%増となる当たり年であったことが大きい。 「ムーアの法則は終わった」、NVIDIAのCEOが言及

「ムーアの法則は終わった」、NVIDIAのCEOが言及

台湾・台北で開催された「COMPUTEX TAIPEI 2017」で、NVIDIAのCEOであるJensen Huang氏は、「ムーアの法則は終わった。マイクロプロセッサはもはや、かつてのようなレベルでの微細化は不可能だ」と、ムーアの法則の限界について言及した。 NVIDIAが解説するディープラーニングの基礎(前編)

NVIDIAが解説するディープラーニングの基礎(前編)

エヌビディアは2018年4月24日、ディープラーニングに関するセミナー「NVIDIA Deep Learning Seminar 2018」を東京都内で開催した。本稿では、セッション「これから始める人のためのディープラーニング基礎講座」から、ディープラーニングの歴史や概要、学習の流れについて紹介する。 Nintendo Switchのチップ解剖から考えるデグレード版Tegra X1を選んだ理由

Nintendo Switchのチップ解剖から考えるデグレード版Tegra X1を選んだ理由

今回は、任天堂の歴代ゲーム機の搭載チップを簡単に振り返りつつ、2017年3月発売の新型ゲーム機「Nintendo Switch」の搭載チップについて考察する。発売前「カスタマイズされたTegraプロセッサ」とアナウンスされたプロセッサの内部は、意外にも「Tegra X1」の“デグレート版”だった……。 NVIDIAのAI技術、Uberが自動運転車に採用へ

NVIDIAのAI技術、Uberが自動運転車に採用へ

NVIDIAは「CES 2018」のプレスカンファレンスで、Uber Technologiesの自動運転車に同社のAI(人工知能)技術が採用されると発表した。自動運転分野におけるNVIDIAの快進撃は止まらないようだ。 トヨタがNVIDIAのAI技術を採用、Intelに焦りか

トヨタがNVIDIAのAI技術を採用、Intelに焦りか

2017年5月10日、トヨタ自動車がNVIDIAのAI(人工知能)プラットフォームを採用する計画を明かした。自動車用AIプラットフォームを巡っては、Mobileye買収をするIntelと、NVIDIAが激しく競り合う。トヨタの採用でNVIDIAの優勢が明白になったが、勝敗の決着はまだ先のようだ。【訂正】

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- Raspberry PiがAIカメラモジュール発売へ、ソニーのAI処理機能搭載センサー採用

- 「FinFETの終えん」に備える 今後10年でGAAへの移行が加速?

- ルネサス甲府工場がいよいよ再稼働 柴田社長「パワー半導体の戦略的拠点に」

- 就業人員の4割が帰還組、ルネサス甲府工場が10年の時を経て再稼働

- 2024年はDRAM/NAND市場が回復へ 需給バランスも正常化

- 日本伝統の「和装柄」がヒントに 半導体の高度な熱管理につながる技術

- 信越化学が国内に新生産拠点、半導体露光材料事業の拡大に向け

- 受託開発の内容を「メニュー」としてサービス化、日立が本格展開

- 半導体製造装置の販売額、2023年は1063億ドルで前年比1.3%減

- MicrochipがTSMCとの提携を拡大、JASMを通じて40nm特化の生産能力を確保