AIはFPGAのスイートスポット、Xilinxがエッジ推論をデモ:最新ネットワークへの対応が速い(1/2 ページ)

Xilinxは、組み込み技術の国際展示会「embedded world 2019」(2019年2月26〜28日、ドイツ・ニュルンベルク)で、自動車や監視カメラなどでの推論、いわゆるエッジデバイスでの推論をイメージしたデモを展示した。

Xilinxは、組み込み技術の国際展示会「embedded world 2019」(2019年2月26〜28日、ドイツ・ニュルンベルク)で、自動車や監視カメラなどでの推論、いわゆるエッジデバイスでの推論をイメージしたデモを展示した。

機械学習/深層学習は、学習と推論に分けられるが、Xilinxが注力するのは推論のみである。現在、NVIDIAやIntelなどが開発を加速させ、激しい競争を繰り広げている「AI(人工知能)向けチップ」は、基本的に学習向けである。だが、Barklays Researchなどの調査会社は、今後はエッジでの推論が大きく伸びると予測している。XilinxのArtificial Intelligence and Edge Computingでプロダクトマーケティングディレクターを務めるNick Ni氏は、「当社は、そこを取りに行く」と強調する。

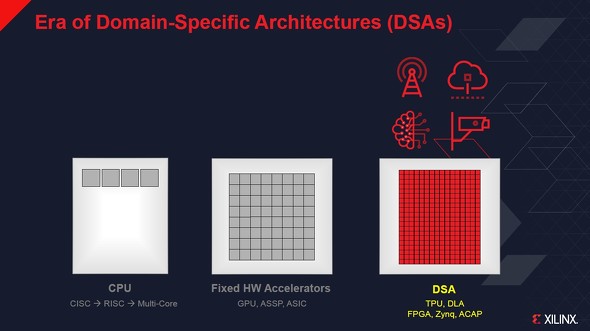

Ni氏は「半導体ICの進化は、デナード則は限界に達し、マルチコア化や、いわゆる『ムーアの法則』も限界が見えている。では、ハードウェアはもう進化できないのか、というと答えはノーだ」と述べる。

ただし、それには新しいアーキテクチャが必要になると多くの専門家が述べている。そこで注目されているのが、DSA(Domain Specific Architecture)だ。これは、異なるワークロードに対して、それぞれ異なるアーキテクチャが必要だ、という考え方である。「だが、何万、何十万というアプリケーションに対して、個別にハードウェアを開発するのは現実的ではない。そこで、プログラマブルなFPGAの強みが生きてくる」(Ni氏)

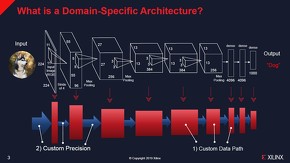

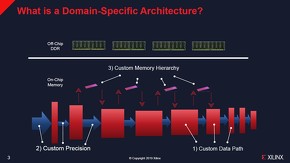

機械学習/深層学習の演算で主にカスタマイズが必要になるのは、データパスと精度(8ビット、4ビットなど)、そしてメモリとの接続である。Ni氏は、「AIのアプリケーションで最も重要なのは、(CNN[Convolutional Neural Network]やRNN[Recurrent Neural Network]などの)ネットワークによってこれら3つを適切に変えていくことだ」と説明する。

ごく単純なクラシフィケーションでも、これだけの演算を行っている。機械学習/深層学習の演算で主にカスタマイズが必要になるのは、図版の1)データパスと2)精度、3)メモリとの接続である 出典:Xilinx(クリックで拡大)

ごく単純なクラシフィケーションでも、これだけの演算を行っている。機械学習/深層学習の演算で主にカスタマイズが必要になるのは、図版の1)データパスと2)精度、3)メモリとの接続である 出典:Xilinx(クリックで拡大)AIのアプリケーションは多岐にわたる上に、AIに使用するネットワークは無数にあり、現在も精度の改善を図りながら増え続けている。「最新のネットワークに追い付くために、NVIDIAやGoogleなどは毎年、新しいチップを発表し続けている」(Ni氏)

「これは、やはり大変なこと。新しいチップを開発するには最低でも2年はかかるし、リスクもある。しかも2年後を予測して開発しなければならない。AIのような、変化が速い市場でそれは難しい。一方でFPGAを使えば、『このネットワークや用途ならば、このハードウェア設計』『これなら、こっちのハードウェア設計』といったように、まったく同じチップで数カ月、もしくは数週間の単位でハードウェア設計を変更することができる。そのため、常に、最新のネットワークに対して最も効率のよい回路を作ることが可能だ」(Ni氏)

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- 2023年の世界半導体売上高ランキングトップ20、NVIDIAが初の2位に

- 中国政府の「Intel/AMD禁止令」、中国企業への強い追い風に

- 就業人員の4割が帰還組、ルネサス甲府工場が10年の時を経て再稼働

- 日本伝統の「和装柄」がヒントに 半導体の高度な熱管理につながる技術

- ルネサス甲府工場がいよいよ再稼働 柴田社長「パワー半導体の戦略的拠点に」

- Raspberry PiがAIカメラモジュール発売へ、ソニーのAI処理機能搭載センサー採用

- 半導体製造装置の販売額、2023年は1063億ドルで前年比1.3%減

- 「FinFETの終えん」に備える 今後10年でGAAへの移行が加速?

- Rapidus、シリコンバレーに新会社設立 AI半導体の顧客開拓を加速

- 2024年はDRAM/NAND市場が回復へ 需給バランスも正常化