開き直る人工知能 〜 「完璧さ」を捨てた故に進歩した稀有な技術:Over the AI ―― AIの向こう側に(14)(6/9 ページ)

Googleが音声認識技術を開発できた理由

では、一体どうやって、Googleは、私に「腰が抜けた」と言わしめる程の、音声認識技術を開発できたのか?

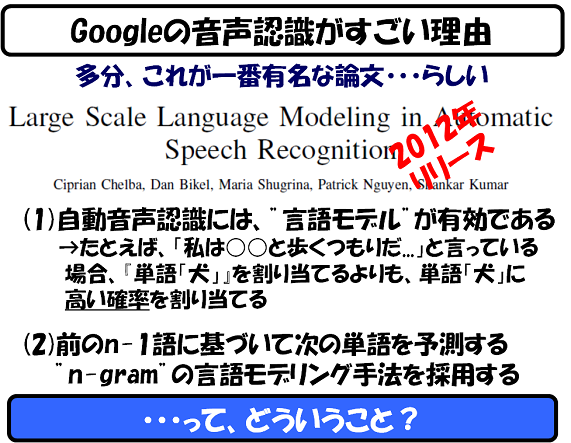

今回、いろいろ調べてみたのですが、どうも、これについて丁寧な解説をしている日本語の文章を見つけられませんでした。仕方がないので、今回ばかりは江端方式(関連記事:論文や特許明細書の英語は“読まない”で“推測する”)を使って、Googleの出している論文を一通りざーっと読んでみました。

この論文の発表が、冒頭で紹介した、Googleトレンドで2012年にトリガとして観測された原因の可能性があります(ウラは取れていません)。

まあ、それはさておき、はっきり言って論文の内容が「分からん」。

エンジニアとしては失当の発言かもしれないのですが、そもそも、何で、音声認識に「予測」なんぞが登場してくるのか、さっぱり理解できなかったのです。

で、私なりに、この論文の根拠となっていることは、こういうことなんじゃないかなーと、考えを纏めてみたのが、以下の図です。

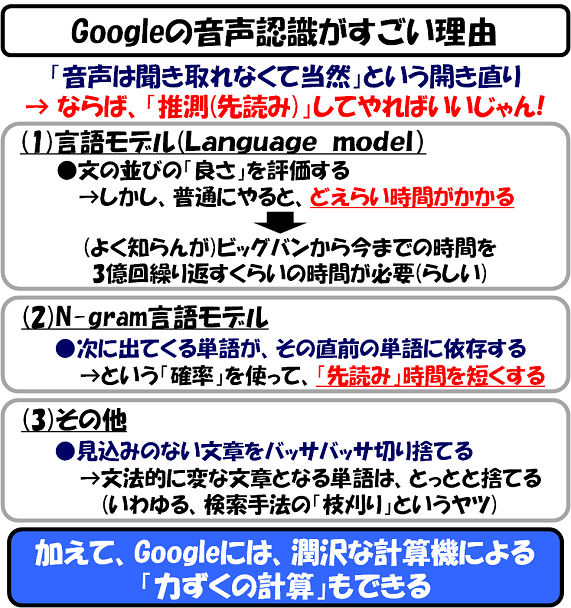

私なりに読み解いた結果、Googleは、

―― 音声なんぞ、そもそも聞き取れないものだろう?

という、ものすごい開き直りをしている、と私は理解しました。

そのような「聞き取れない音声」を推測するためには、「言語モデル(Language Model)という「文の並び」のテンプレートを用意しておき、そこに当てはまるかどうかを評価してやればいい、という考え方があります。

しかし、「文の並び」のテンプレートを当てはめて、真面目にその良さを評価した場合、その評価に必要な時間は、宇宙の年齢を3億倍する時間よりもかかる、という文献も見つけました。

そこで、登場してきたのが、N-gramモデルです。N-gramモデルは、次の「音節」が聞こえてくる「前」に、過去の1つ以上の音節を使って、次に登場する可能性の高い音節の幾つかを取り出して「待ち構えていればいい」という、従来の音声認識技術では使えなかった、逆転の発想を行います。

さらに、見込みのない文章を作ってしまう音節なら、早々に切り捨てる(文法的に、ハチャメチャなフレーズになるなら、切り捨てるとか)などして、「待ち構えている」数をさらに減らします。

なぜこの技術が従来使えなかったかというと、この方法を使うためには、世界規模の膨大な(そんじょそこらの「膨大」とはケタの違う「膨大」な)音声データとそれに対応するテキストデータの両方を同時に収集し、そんな膨大な情報を、「本当に」で処理できる計算リソースとエンジニアの両方が必要であり、そのような企業は、世界でGoogleくらいしかなかったからだ、と思っています。

つまり、Googleの音声認識技術のキモは、「すごい技術の発明」―― というよりは、むしろ、毎日集まってくる、宇宙規模の膨大な音声情報を、"理論上"ではなく、"現実"に処理することのできるシステムを、"理論上"ではなく、"現実"に作ってみせた ―― という点にある、と私は読み取りました。

Copyright © ITmedia, Inc. All Rights Reserved.

記事ランキング

- 2023年の世界半導体売上高ランキングトップ20、NVIDIAが初の2位に

- 中国政府の「Intel/AMD禁止令」、中国企業への強い追い風に

- 就業人員の4割が帰還組、ルネサス甲府工場が10年の時を経て再稼働

- 日本伝統の「和装柄」がヒントに 半導体の高度な熱管理につながる技術

- JDI、次世代有機ELディスプレイ「eLEAP」を24年12月に量産開始へ

- ルネサス甲府工場がいよいよ再稼働 柴田社長「パワー半導体の戦略的拠点に」

- Raspberry PiがAIカメラモジュール発売へ、ソニーのAI処理機能搭載センサー採用

- 半導体製造装置の販売額、2023年は1063億ドルで前年比1.3%減

- 全固体ナトリウム電池の量産化に向けた新合成プロセスを開発、大阪公立大

- Rapidus、シリコンバレーに新会社設立 AI半導体の顧客開拓を加速